| . |

|

||||||

|

|

| . |

|

||||||

L'intelligence

artificielle ( = IA) est un domaine de l'informatique tourné

vers le développement de systèmes capables d'effectuer des tâches qui

nécessitent ordinairement l'intelligence

humaine, par exemple, la résolution de problèmes, l'apprentissage, la

reconnaissance de la parole, la prise de décision, la compréhension

du langage naturel et la vision par ordinateur, etc. On n'attend pas des

systèmes d'intelligence artificielle qu'ils fonctionnent comme l'esprit

humain - et, de fait, ils en sont aujourd'hui très loin, et le terme d'intelligence

est ici trompeur - mais seulement qu'ils accomplissent certaines tâches

dont la réalisation requiert chez eux un recours à leurs capacités cognitives.

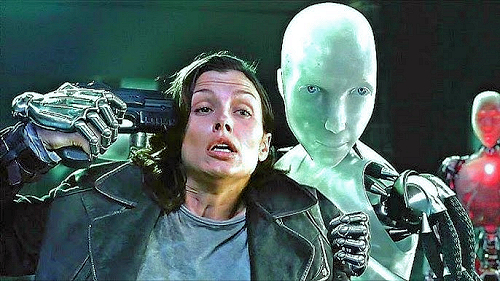

Les visages de l'intelligence artificielleIA faible et IA forte.En fonction des capacités des systèmes d'intelligence artificielle, on distingue ordinairement l'IA faible et l'IA forte. La première se réfère à des systèmes d'intelligence artificielle conçus et entraînés pour accomplir des tâches spécifiques ou résoudre des problèmes limités. La seconde, dont la possibilité est encore spéculative, aspirerait à une intelligence générale comparable à celle des êtres humains, prétendrait à une compréhension ou une conscience globales et pourrait éventuellement ressentir des émotions et des sentiments. L'IA

faible.

Les types d' IA faible. • IA basée sur des règles (Rule-Based AI). - Ces systèmes fonctionnent en suivant des ensembles prédéfinis de règles ou de conditions if-then ( = si-alors). Exemples : systèmes experts utilisés pour le diagnostic médical, logiciels de gestion de la conformité légale.L'IA forte. L'IA forte est encore (2024) à l'état de projets. Elle devrait être capable de comprendre et de raisonner sur un large éventail de sujets, sans être limitée à des tâches spécifiques. Elle devrait pouvoir interpréter des informations contextuelles, formuler des hypothèses et résoudre des problèmes complexes de manière similaire à un être humain. Elle devrait pouvoir acquérir de nouvelles compétences et connaissances de manière autonome, sans nécessiter d'interventions humaines pour chaque nouvelle tâche. Elle devrait être capable de transférer des connaissances d'un domaine à un autre. Par oppoistion à l'IA faible capable seulement d'exécuter des tâches spécifique, elle pourrait être qualifiée d'IA générale (IAG). Mais l'IA forte pourrait, de plus, posséder une certaine forme de conscience ou de compréhension de soi, ce qui lui permettrait de réfléchir sur ses propres actions et décisions. Elle devrait pouvoir prendre, par exemple, la forme d'un robot humanoïde capable de réaliser toutes les tâches qu'un humain peut accomplir, comme converser naturellement, créer des oeuvres d'art, comprendre et exprimer des émotions, résoudre des problèmes complexes, et bien plus encore. Ce serait surtout un système informatique capable d'apprendre n'importe quelle nouvelle compétence à un niveau expert, quel que soit le domaine, sans nécessiter de nouvelles programmations ou interventions humaines spécifiques. Actuellement, l'IA forte reste un objectif théorique et non réalisé. Les chercheurs travaillent activement sur des aspects fondamentaux de l'intelligence générale, comme l'apprentissage non supervisé, le transfert de connaissances, et la compréhension contextuelle, mais il reste encore de nombreux défis techniques à surmonter avant d'atteindre une véritable IA forte. L'IA forte représente le sommet de la recherche en intelligence artificielle. Mais la création de l'IA forte soulève des questions éthiques complexes, notamment sur les droits des machines conscientes, l'impact sur l'emploi, et les risques potentiels pour la sécurité humaine. Que peut-on attendre (espérer ou craindre) d'une IA capable de rivaliser avec l'intelligence humaine dans toutes les tâches intellectuelles? Pourra-t-on attribuer une forme de conscience ou de subjectivité aux systèmes d'IA générale? Quelle est la nature de la compréhension qu'une machine pourrait avoir de son propre état ou de son environnement? Quels risques cela fait-il courir à l'espèce humaine? Comment minimiser les menaces potentielles posées par des systèmes d'IA puissants et autonomes? Quels pourraient être les impacts sur la compréhension de nous-mêmes et de notre place dans le monde si une telle IA était créée? Comment l'interaction avec des machines intelligentes modifierait-t-elle notre conception de l'humanité? Types

théoriques d'IA forte.

• IA cognitive. - Inspirée par la structure et le fonctionnement du cerveau humain, cette IA chercherait à reproduire les processus cognitifs humains, comme la perception, le raisonnement, l'apprentissage et la mémoire. Exemple théorique : une machine capable de penser et de résoudre des problèmes de la même manière qu'un humain, utilisant des réseaux de neurones artificiels très avancés. Questions philosophies et éthiquesQu'est-ce que comprendre?Pour un humain, comprendre implique de saisir les relations entre les différentes parties d'un tout, de voir comment les concepts se connectent et interagissent. Par exemple, comprendre une théorie scientifique signifie non seulement connaître ses faits et ses principes, mais aussi voir comment ils se relient de manière cohérente. Pour une IA, "comprendre" signifie généralement qu'elle est capable de traiter et d'interpréter des informations d'une manière qui lui permet de répondre aux questions ou aux tâches qui lui sont posées de manière contextuelle et appropriée. Cela va au-delà de la simple récitation de faits pour inclure la capacité à raisonner, inférer, et résoudre des problèmes. Cependant, cette compréhension est très différente de la compréhension humaine. La compréhension de l'IA est limitée par l'absence de conscience et d'expérience subjective. Les IA ne peuvent pas "ressentir" ou "vivre" les informations de la même manière que les humains, et leur compréhension est confinée aux paramètres et aux données avec lesquels elles ont été formées. Une IA peut analyser des données et produire des résultats en se basant sur des algorithmes, sans nécessairement saisir le sens ou la signification profonde des informations. Par exemple, une IA peut traiter un texte en utilisant des modèles statistiques pour prédire la prochaine phrase, ou même seulement le prochain mot ou la prochaine lettre, sans comprendre réellement le contenu du texte. Les IA modernes, comme les modèles de traitement du langage naturel, utilisent des contextes et des relations entre les mots pour améliorer leur performance. Cependant, cette contextualisation est basée sur des statistiques et des patterns (= modèles) appris plutôt que sur une compréhension consciente du contenu. Contrairement aux humains, les IA n'ont pas de conscience ou d'expérience subjective. Elles n'ont pas de sensations, d'émotions ou de perceptions, ce qui signifie que leur "compréhension" est purement fonctionnelle et algorithmique. Elles ne saisissent pas le sens de la manière dont les humains le font. Les IA peuvent intégrer et utiliser des connaissances à partir de vastes ensembles de données. Cependant, cette connaissance est déconnectée de l'expérience personnelle ou de la signification profonde. Par exemple, une IA peut savoir que "les chats ont des moustaches" parce qu'elle a été formée sur des images et des textes contenant cette information, mais elle ne comprend pas ce que cela signifie en termes d'expérience sensorielle ou d'interaction avec le monde. Les IA symboliques utilisent des règles et des représentations explicites pour traiter les informations, tandis que les IA connectionnistes (comme les réseaux neuronaux) apprennent des représentations implicites à partir de données. La "compréhension" dans l'IA connectionniste est souvent moins explicite et plus difficile à interpréter. Dans des applications comme les assistants virtuels, les systèmes de recommandation ou les traducteurs automatiques, les IA montrent une forme de compréhension fonctionnelle qui est suffisante pour accomplir des tâches spécifiques. Cependant, cette compréhension est limitée à des contextes prédéfinis et ne s'étend pas à une conscience ou une compréhension généralisée. Les test de l'IA.

Le

test de Turing.

Le test de Turing soulève des questions sur la nature de l'intelligence et de la conscience. Peut-on considérer une machine comme "intelligente" simplement parce qu'elle imite les réponses humaines de manière convaincante ? Le test ne prend pas en compte la conscience ou la subjectivité. Une machine pourrait réussir le test de Turing sans avoir de conscience ou de compréhension réelle des réponses qu'elle donne. Le test de Turing a motivé des recherches en IA visant à créer des machines capables de comprendre et de générer un langage naturel de manière convaincante. Les IA actuelles, comme les chatbots sophistiqués, peuvent imiter des conversations humaines dans certaines limites, mais souvent, elles restent incapable de prendre en compte réellement le contexte ou les nuances des interactions. Le test a des limitations.

Il se base sur la capacité de l'IA à imiter un comportement humain en

surface sans évaluer la profondeur de la compréhension ou de la pensée.

Les jugements des évaluateurs peuvent aussi être biaisés par leurs attentes

et leurs connaissances préalables sur l'IA, ce qui peut affecter les résultats

du test. Aussi, divers tests et critères ont été proposés pour évaluer

l'intelligence et les capacités des IA, tels que le test de Lovelace (qui

vérifie si une IA peut produire quelque chose de créatif de manière

autonome) et le test de la salle chinoise de John Searle (qui teste la

compréhension réelle au regard de la manipulation de symboles).

Le

test de Lovelace.

L'IA doit, ainsi, dans le domaine de l'art, être capable de créer des peintures ou des compositions musicales qui ne sont pas seulement des amalgames d'oeuvres humaines, mais qui possèdent des qualités uniques et nouvelles. Testée dans le domaine de la littérature, elle doit écrire des poèmes ou des histoires avec des thèmes et des styles originaux, qui ne se contentent pas de recycler des motifs littéraires bien connus. Dans le domaine de l'innovation scientifique, elle doit pouvoir proposer des hypothèses scientifiques ou des solutions techniques qui sont nouvelles et utiles, non dérivées directement de la base de données existante. Comme le test de Turing, le test de Lovelace se heurte à des défis. Par exemple, déterminer si une création est réellement originale peut être subjectif et difficile à mesurer de manière objective. De plus, les critères mis en oeuvre sont particulièrement difficiles à évaluer, car ils impliquent une forme de conscience ou de compréhension profonde qui est actuellement hors de portée des IA modernes. A ce jour, alors même que les IA actuelles montrent des capacités impressionnantes, elles n'ont pas encore atteint le niveau de compréhension et d'intention que le test de Lovelace exige. Le

test de la chambre chinoise.

Searle utilise cette expérience pour illustrer la différence entre la manipulation syntaxique des symboles (ce que fait l'ordinateur) et la compréhension sémantique des significations (ce que fait un être humain). Searle soutient que les ordinateurs, qui fonctionnent par manipulation syntaxique de symboles, ne peuvent jamais vraiment « comprendre » ou avoir des états mentaux, même s'ils peuvent sembler intelligents. C'est un argument à l'encontre de l'idée de l'IA forte, qui affirme qu'un système informatique peut réellement avoir une conscience et une compréhension comme les humains. L'expérience de la chambre chinoise remet en question des tests comme le test de Turing, qui évalue l'intelligence d'une machine en fonction de son comportement observable. Searle argumente que même si une machine peut passer le test de Turing, cela ne prouve pas qu'elle comprend ou qu'elle est consciente. L'argument de Searle milite en faveur l'idée de l'IA faible, où les systèmes d'IA sont des outils puissants pour résoudre des problèmes spécifiques sans prétendre qu'ils possèdent une véritable intelligence ou conscience. L'argumentation

de Gödel.

En effet, si l'esprit humain était équivalent à un système formel, alors, selon les théorèmes de Gödel, il devrait exister des vérités que l'esprit humain ne peut pas comprendre ou prouver. Or, les êtres humains semblent capables de reconnaître la vérité de certaines propositions non prouvables au sein d'un système formel donné, ce qui suggère que l'esprit humain n'est pas limité de la même manière que les systèmes formels. Si donc l'esprit humain dépasse les limites des systèmes formels (comme le suggère la capacité humaine à percevoir des vérités non prouvables dans ces systèmes), alors il y a quelque chose dans l'intelligence humaine qui ne peut pas être entièrement saisi par un système formel ou par un programme d'ordinateur. Par conséquent, une machine basée sur un système formel ne pourrait jamais posséder l'intelligence et la compréhension humaine dans leur totalité, ce qui contredit l'idée de l'IA forte. L'argument de Gödel, comme les précédents est largement débattu. Ses partisans, comme le philosophe John Lucas et plus tard Roger Penrose, soutiennent que l'esprit humain doit inclure des éléments non algorithmique pour échapper aux limitations des systèmes formels. Mais certains philosophes et mathématiciens soutiennent de leur côté que la capacité humaine à percevoir des vérités non prouvables ne prouve pas nécessairement que l'esprit humain n'est pas un système formel. Il pourrait simplement indiquer que les humains utilisent des méta-systèmes ou des approches heuristiques qui ne sont pas capturés par un seul système formel. Les démonstrations

mathématiques et l'IA.

L'IA peut être utilisée pour analyser et tester des conjectures mathématiques. Des outils basés sur l'IA, comme ceux développés par OpenAI (par exemple, GPT-4 ou OpenAI Codex basé sur GPT-3, qui peut générer des explications de concepts mathématiques et aider à rédiger des preuves en langage naturel, ce qui peut être utile pour la vulgarisation et l'enseignement des mathématiques), peuvent aider les mathématiciens à étudier des conjectures, à formuler des hypothèses et à trouver des idées nouvelles en analysant de grandes quantités de données et de publications mathématiques. Ils peuvent proposer des étapes intermédiaires ou des connexions entre différents domaines des mathématiques. Les systèmes tutoriels intelligents peuvent aider à apprendre les mathématiques en leur proposant des exercices adaptés à leur niveau et en fournissant des démonstrations détaillées. Ils peuvent aussi offrir des explications interactives et personnalisées. Des outils spécialisés, peuvent permettre d'aller encore plus loin. Par exemple, les systèmes de démonstration automatique, comme Coq, Isabelle, Mizar et Lean, sont capables de vérifier et parfois de générer des preuves mathématiques. Le projet Formal Abstracts vise à formaliser une grande partie des mathématiques en utilisant ces outils. Ces systèmes utilisent des techniques telles que la logique formelle, les théories des types et les algorithmes de recherche pour prouver des théorèmes ou vérifier la validité de démonstrations. Google DeepMind a développé des modèles d'IA capables de découvrir des conjectures et des démonstrations en mathématiques pures, comme en théorie des noeuds et en théorie des représentations. Ces modèles peuvent générer des intuitions et des idées qui aident les mathématiciens humains à aborder de nouvelles directions. Le statut épistémologique d'un énoncé mathématique produit par une intelligence artificielle (IA), mais dont il n'est pas possible d'apporter une validation par un humain, soulève plusieurs questions importantes en philosophie des mathématiques et en épistémologie. Les mathématiques sont traditionnellement une activité humaine. Une démonstration mathématique n'est pas seulement un déploiement de symboles agencé logiquement. C'est aussi la composante d'un acte de communication qui doit recevoir la validation de son destinataire (la communauté des mathématiciens, qui jusqu'à meilleure informée sont tous des humains, avec donc les limitations inhérantes à leur condition). La valeur d'un résultat mathématique dépend de sa vérifiabilité, de sa compréhension et de l'acceptation par la communauté mathématique. La vérification de la validité des démonstrations générées par l'IA reste un défi, car certaines preuves peuvent être très complexes ou utiliser des étapes non intuitives. Pour qu'un résultat mathématique obtenu par une IA soit considéré comme valable, il doit être vérifiable de manière indépendante par des méthodes formelles. Les outils de preuve automatique et les assistants de preuve, comme Coq, Lean, et Isabelle, permettent de formaliser et de vérifier les preuves de manière rigoureuse. Si une preuve obtenue par une IA peut être validée par ces systèmes, elle gagne en crédibilité. Un énoncé mathématique produit par une IA sans validation humaine pose la question de savoir s'il reste une partie intégrante de la discipline mathématique ou s'il s'agit d'une sorte de « mathématiques automatisées » distinctes. Le théorème des quatre couleurs a été le premier théorème majeur à être démontré avec l'aide d'un ordinateur en 1976. La démonstration initiale, qui nécessitait une vérification exhaustive par ordinateur, a soulevé des questions sur la validité et la compréhension des preuves assistées par ordinateur. Cependant, avec le temps, cette méthode a été acceptée. L'IA peut être vue comme un producteur d'énoncés mathématiques selon une épistémologie différente, une épistémologie mécanique ou ou épistémologie des machines, où les énoncés sont produits par des mécanismes computationnels plutôt que par des intuitions ou des preuves humaines. L'IA pourrait être considérée comme une nouvelle source d'autorité épistémique. Cependant, cette autorité doit être justifiée par une compréhension profonde de ses méthodes et de ses limites. Une autre question est aussi de savoir que faire d'un énoncé produit par l'IA et qui n'a pas reçu de validation humaine. Dans les domaines où une vérification humaine exhaustive est impossible (par exemple, la cryptographie ou la théorie des graphes à grande échelle), les résultats produits par l'IA pourraient être utilisés de manière pragmatique avec une acceptation de l'incertitude. Des approches comme celle de la logique floue permettent d'intégrer dans un système formel des énoncés qui ont des valeurs de vérité intermédiaires (ils peuvent très bien ne pas être tout à fait vrais ou tout à fait faux) comme c'est le cas des énoncés démontrés par IA et non validés par un humain. Il est simplement alors crucial de reconnaître les limites des énoncés produits par les IA et de ne pas les considérer automatiquement comme des vérités établies sans validation indépendante. L'IA et l'humanité

future.

Le posthumanisme, quant à lui, est une perspective philosophique qui remet en question les notions traditionnelles de l'humanité et propose une réévaluation des rapports entre les humains, les technologies et l'environnement. Le posthumanisme s'interroge sur ce que signifie être humain dans un monde où les technologies avancées, notamment l'IA, sont omniprésentes. Il propose une vision où les distinctions entre l'humain, la machine et l'animal deviennent floues. Les développements en IA posent des questions sur la nature de la conscience et de la subjectivité. Si une IA atteint un niveau de sophistication suffisant pour simuler des aspects de la conscience humaine, cela pourrait transformer notre compréhension de la subjectivité et de l'expérience. Le posthumanisme s'intéresse à la manière dont l'IA pourrait permettre des formes de coévolution et de symbiose entre les humains et les technologies. Cela inclut des réflexions sur des écosystèmes technologiques où les IA et les humains coexistent et collaborent. Les valeurs posthumanistes invitent à une remise en question des hiérarchies traditionnelles et une reconnaissance de la diversité des formes d'intelligence et de vie. L'IA est vue comme un agent capable de participer à cette diversité, nécessitant une reconsidération des cadres éthiques et des droits. La

singularité technologique.

• John von Neumann (1903-1957) a discuté dès les années 1950 d'un « progrès technologique accéléré » et d'une « singularité essentielle » dans l'histoire humaine. Il a parlé de la rapidité croissante du progrès technologique et de l'approche d'un point où la technologie pourrait transformer radicalement la société. Von Neumann voyait cela comme un changement exponentiel qui pourrait redéfinir la civilisation humaine.Face à cette perspective, certains, comme Ray Kurzweil, se montrent optimistes. L'humanité pourrait bénéficier d'avancées rapides dans la compréhension scientifique et les technologies médicales, potentiellement conduisant à des solutions pour des maladies incurables et à une amélioration radicale de la qualité de vie. Les technologies augmentant les capacités intellectuelles et physiques humaines, elles pourraient nous mener vers une ère post-humaine. D'autres, comme Nick Bostrom, sont pessimistes. Ils soulignent la possibilité de la perte de contrôle sur les machines super-intelligentes qu'une telle évolution signifierait, avec des conséquences imprévisibles et potentiellement catastrophiques. Ils en appellent à des mesures de précaution strictes. Il existe aussi au troisème option, face à la singularité technlogique, celle dite des réalistes, des chercheurs pour qui les scénarios de la singularité sont basés sur des extrapolations par trop spéculatives. Ils considèrent que les défis techniques pour atteindre l'IA générale sont sous-estimés. La réalité est-elle

une simulation?

Selon Bostrom, les progrès technologiques pourraient un jour permettre aux civilisations avancées de créer des simulations extrêmement complexes qui reproduisent la réalité à un niveau de détail indiscernable. Si une civilisation peut créer des simulations, il est probable qu'elle en crée beaucoup. Si ces simulations sont nombreuses, il devient statistiquement probable que nous soyons dans l'une d'entre elles plutôt que dans la réalité tout court. En considérant l'évolution technologique continue de l'humanité, il semble possible que des générations futures possèdent des ordinateurs capables de simuler des univers entiers avec des entités conscientes. Bostrom va jusqu'Ã

imaginer que nous soyons capables un jour de simuler des univers dans lesquels

ces entités conscientes deviendraient assez avancées pour créer elles-mêmes

des simulations d'univers dans lesquelles des entités conscientes pourraient

à leur tour créer des simulations, et ainsi de suite, à l'infini. Dans

ce cas, rien n'empêche que nous soyons nous-mêmes des simulations créées

par ds simulations, elles-mêmes créées par des simulations, et ainsi

de suite jusqu'à ...? Une mise en abyme vertigineuse de la réalité qui

devient alors un concept insaisissable.

De toute façon, quel que soit le niveau d'intrication de la réalité que l'on imagine, si nous vivons dans une simulation, cela pose des questions fondamentales sur la nature de la réalité. Par exemple, les lois physiques que nous observons pourraient être des règles programmées plutôt que des vérités fondamentales de l'univers. L'idée de vivre dans une simulation pourrait impliquer que nos actions sont déterminées par des algorithmes ou que nous avons une forme limitée de libre arbitre. Une des faiblesses de l'hypothèse de la simulation en arguant que nous n'avons aucun moyen fiable de tester ou de vérifier cette théorie, ce qui la rend spéculative et non scientifique. Certaines anomalies ou limites dans les lois de la physique pourraient-elles se comprendre comme des indices sur la nature simulée de notre univers? Le physicien Thomas Campbell a proposé en 2017 des tests qui pourraient permettre de mettre à l'épreuve l'hypothèse de la simulation, même si l'argument de Gödel semble aller à l'encontre de tels tests. De toute façon, l'hypothèse de la simulation ne permet de répondre à aucune question de fond concernant le réel. Elle ne fait que repousser la problématique derrière un voile pittoresque en posant des questions que rien n'impose. Il semble bien plus simple et plus rationnel d'appliquer le rasoir d'Occam et d'admettre que nous vivons dans la réalité de base, car cette hypothèse ne requiert pas d'entités ou de technologies supplémentaires. . L'éthique de

l'intellligence artificielle.

Des questions concernent aussi la transparence et l'explicabilité de ce ce type d'outil. Comment rendre les décisions des systèmes d'IA compréhensibles pour les humains? Et d'ailleurs, la transparence et l'explicabilité sont-elles véritablement nécessaires pour garantir une utilisation éthique de l'IA, en particulier dans la santé, la justice ou la finance? Quel va être l'impact de l'IA sur le marché du travail, sur les libertés individuelles et les libertés publqiues? Comment la société doit-elle faire face à la transition vers une utilisation accrue de l'IA dans les processus de production et de services? Les

trois lois de la robotique d'Asimov.

• Première loi (sécurité et le bien-être humain) : « un robot ne peut porter atteinte à un être humain ni, par son inaction, permettre qu'un être humain soit exposé au danger ». En pratique, cela nécessite des systèmes de surveillance et de contrôle rigoureux pour éviter les comportements imprévus ou dangereux des IA.Après avoir énoncé ces lois Asimov s'est attaché malicieusement à montrer comment elles pouvaient être contournées. Autrement dit, elles n'étaient sans doute pour lui, u final, qu'une forme de contrainte littéraire destinée à stimuler sa créativité (un peu à la manière des contraintes que se donnent les écrivains de l'Oulipo). Et, de fait, les lois de la robotique apparaissent trop simples pour s'appliquer à des situations réelles. Elle sont sujettes à interprétation et se montrer incapables de répondre aux complexités du réel. Elles sont aussi insuffisantes, dans la mesure où elles ne prennent pas en compte les questions de justice sociale, de biais et de discrimination qui peuvent émerger dans l'utilisation des IA, d'oubli de la responsabilité des développeurs, de respect de la vie privée, etc. Autrement dit, elles doivent être complétées par des principes éthiques modernes qui prennent en compte la complexité et les nuances des interactions humaines et technologiques.

Confidentialité

et sécurité des données

Les plateformes en ligne utilisent des algorithmes d'IA pour modérer le contenu, ce qui peut conduire à une censure automatisée. Les erreurs dans ces systèmes peuvent supprimer injustement des contenus ou comptes, affectant la liberté d'expression. L'IA peut être utilisée pour créer et diffuser des informations fausses ou trompeuses (deepfakes, bots sociaux), ce qui peut influencer l'opinion publique et nuire au débat démocratique. L'utilisation de technologies de reconnaissance faciale dans les espaces publics peut dissuader les gens de participer à des manifestations ou à d'autres formes d'expression collective, limitant ainsi leur liberté de réunion et d'association. Les systèmes d'IA peuvent perpétuer et amplifier les biais présents dans les données d'entraînement, ce qui peut mener à des décisions discriminatoires dans des domaines tels que l'emploi (recrutement, évaluation des performances, etc.), le crédit, et les services publics. L'accès inégal à l'IA et aux technologies associées peut accentuer les inégalités existantes, limitant les opportunités pour certains groupes de participer pleinement à la société numérique. Les algorithmes d'IA peuvent prendre des décisions importantes sans fournir d'explications claires, ce qui rend difficile pour les individus de comprendre et de contester ces décisions. Cela affecte leur autonomie et leur capacité à exercer leurs droits. Lorsqu'une IA prend une décision qui affecte les libertés individuelles, il peut être difficile de déterminer qui est responsable – les développeurs, les opérateurs ou les utilisateurs de l'IA. Cette ambiguïté peut compliquer la recherche de recours pour les violations de droits. La dépendance excessive à l'IA peut réduire les interactions humaines et nuire à la qualité des services personnalisés, affectant ainsi l'autonomie des individus dans leurs interactions quotidiennes. L'IA peut être utilisée pour influencer et manipuler les comportements des individus, par exemple à travers des publicités ciblées ou des recommandations personnalisées, réduisant ainsi leur liberté de choix. Libertés.

Cela soulève des préoccupations éthiques concernant la vie privée des employés et peut créer un climat de méfiance et de stress. Cela pose des risques pour la vie privée et la liberté de mouvement des individus, et peut créer un climat de surveillance constante. Quand l'IA repose sur des vastes ensembles de données personnelles, la collecte, le stockage, et l'analyse de ces données peuvent porter atteinte à la vie privée des individus, en particulier si ces pratiques sont effectuées sans consentement explicite et éclairé. L'utilisation de l'IA dans la santé nécessite l'accès à des données médicales sensibles. La protection de la confidentialité de ces données est essentielle pour respecter le droit à la vie privée des patients. Les algorithmes d'IA utilisés pour modérer le contenu sur les plateformes en ligne peuvent supprimer ou censurer des contenus de manière injustifiée, affectant ainsi la liberté d'expression. Des erreurs dans ces systèmes peuvent conduire à la suppression de contenus légitimes ou à la diffusion de contenus nuisibles. Egalité.

L'utilisation possible de l'IA pour assister ou remplacer les juges dans la prise de décisions judiciaires pose des questions sur l'équité et la transparence des procès. Les algorithmes peuvent manquer de transparence et de possibilité de contestation, compromettant ainsi le droit à un procès équitable. Les question d'égalité peuvent aussi se poser à propos de ceux qui ont accès aux aspects bénéfiques de l'IA et ceux qui n'y ont pas accès. Par exemple, l'IA a le potentiel d'améliorer l'accès aux soins de santé grâce à des diagnostics plus rapides et plus précis, et à des traitements personnalisés. Cependant, l'inégalité dans l'accès à ces technologies peut créer des disparités dans la qualité des soins de santé disponibles pour différentes populations. Les inégalités d'accès aux technologies avancées de l'IA peuvent également exacerber les disparités économiques et sociales, créant un fossé numérique entre ceux qui ont accès à ces technologies et ceux qui en sont exclus. L'égalité des chances dans le monde du travail et dans l'économie peut être elle aussi affectée de diverses façons par l'IA. Toutes les entreprises, surtout les petites et moyennes, n'ont pas les mêmes moyens d'investir dans l'IA. Cela peut créer un fossé entre les grandes entreprises technologiquement avancées et les plus petites, qui risquent de devenir non compétitives. Les entreprises qui adoptent l'IA peuvent voir une augmentation significative de leur productivité et de leurs profits, ce qui peut accroître la concentration de la richesse entre les mains d'un petit nombre d'entreprises et de leurs dirigeants, exacerbant les inégalités économiques. L'automatisation des tâches par l'IA peut entraîner la suppression de nombreux emplois, en particulier ceux qui sont répétitifs et routiniers. Cela peut conduire à une augmentation du chômage et à une précarité économique pour les travailleurs concernés. Les emplois restants ou nouveaux créés par l'IA nécessiteront des compétences différentes, souvent plus techniques et spécialisées. Il y a un risque que certains travailleurs, notamment ceux des secteurs traditionnels, ne puissent pas s'adapter ou se former à temps, ce qui peut aggraver les inégalités. Explicabilité

et transparence.

La transparence permet d'attribuer la responsabilité en cas d'erreur ou de préjudice. Sans explication claire des décisions prises par l'IA, il devient difficile de déterminer qui est responsable des erreurs – que ce soit les développeurs, les opérateurs ou d'autres parties prenantes. Une transparence insuffisante peut faciliter l'occultation des erreurs ou des abus, rendant difficile la mise en place de mesures correctives appropriées. Cela soulève des préoccupations éthiques sur l'imputabilité des actions prises par ou avec l'aide de l'IA. L'absence de transparence peut masquer des biais dans les algorithmes, entraînant des décisions discriminatoires ou injustes. Les utilisateurs doivent pouvoir vérifier que les systèmes d'IA prennent des décisions de manière équitable et non discriminatoire. La capacité à expliquer les décisions de l'IA permet de détecter et de corriger les biais inhérents aux données ou aux algorithmes. Si les processus décisionnels de l'IA sont opaques, les biais peuvent passer inaperçus et perpétuer des inégalités existantes. Les utilisateurs ont le droit de savoir comment leurs données sont utilisées et comment les décisions les concernant sont prises. Cela est particulièrement important dans des domaines sensibles comme la santé, la justice ou le crédit, où les décisions de l'IA peuvent avoir un impact significatif sur la vie des individus. Pour que le consentement des utilisateurs à l'utilisation de leurs données soit véritablement éclairé, ils doivent comprendre comment ces données seront traitées et à quelles fins. La transparence est donc cruciale pour respecter les droits à la vie privée et au consentement des utilisateurs. Les concepteurs d'IA ont la responsabilité éthique de créer des systèmes transparents et explicables. Cela inclut l'intégration de mécanismes permettant de retracer les décisions et de fournir des explications claires aux utilisateurs. Les développeurs doivent équilibrer l'innovation avec les considérations éthiques. Par exemple, l'utilisation de techniques comme les boîtes noires ( = algorithmes opaques) peut offrir des performances accrues mais au prix de la transparence. Une innovation éthique privilégie la création de systèmes compréhensibles et auditables. Les questions de

transparence et d'explicabilité doivent être abordées par des cadres

réglementaires appropriés. Les législateurs et les régulateurs doivent

définir des normes claires pour garantir que les systèmes d'IA respectent

des principes éthiques.

Responsabilité

et imputabilité

Des régulations

spécifiques doivent être mises en place pour encadrer l'utilisation de

l'IA, en s'assurant qu'elle respecte les normes internationales des droits

humains. Les systèmes d'IA doivent être transparents et explicables,

permettant aux individus de comprendre comment les décisions sont prises

et d'avoir la possibilité de les contester. Les parties prenantes, Ã

commencer par les groupes de défense des droits humains, les populations

affectées (employés, citoyens, etc.) et les experts techniques, doivent

être consultées et impliquées dans le développement et la mise en oeuvre

des technologies d'IA. Il est crucial aussi de former et de sensibiliser

les développeurs, les décideurs politiques et le grand public aux implications

liées à l'irruption massive de l'IA dans nos vies. (Page

rédigée avec l'aide de... ChatGPT).

Enjeux géopolitiques.

Un enjeu central est la domination technologique et économique. Les pays qui seront à la pointe de l'IA bénéficieront d'avantages compétitifs considérables dans de nombreux secteurs : industrie, finance, santé, énergie, défense, etc. Cette domination technologique pourrait se traduire par une influence accrue sur le commerce mondial, la définition des normes technologiques, et la capacité à façonner les chaînes de valeur globales. On observe déjà une course entre les États-Unis, la Chine et, dans une moindre mesure, l'Union Européenne, pour attirer les talents, investir massivement dans la recherche et développement en IA, et déployer des infrastructures numériques robustes. Cette compétition pourrait exacerber les tensions commerciales et technologiques existantes. Un autre enjeu crucial est la sécurité et la défense. L'IA transforme profondément le domaine militaire, avec le développement d'armes autonomes, de systèmes de surveillance sophistiqués, de cyberattaques plus efficaces, et d'outils de désinformation avancés. La course aux armements dans le domaine de l'IA pourrait déstabiliser les équilibres stratégiques et accroître les risques de conflits. La question du contrôle et de la régulation des armes autonomes est particulièrement sensible et divise les nations. Parallèlement, l'IA peut être utilisée pour améliorer la cybersécurité et la défense contre les menaces numériques, créant ainsi une dynamique complexe de course à l'armement défensif et offensif. La souveraineté numérique et la gestion des données sont également des enjeux géopolitiques majeurs. L'IA repose sur de grandes quantités de données, et le contrôle de ces données devient un enjeu de pouvoir. Les pays cherchent à protéger les données de leurs citoyens et de leurs entreprises, à imposer des règles de localisation des données, et à développer des infrastructures numériques souveraines. Cette volonté de souveraineté numérique peut entrer en conflit avec la nature transfrontalière de l'internet et des technologies de l'IA, et créer des tensions entre les États. La question de la gouvernance des données à l'échelle mondiale, notamment en matière de protection de la vie privée et de sécurité, est essentielle pour éviter une fragmentation numérique et garantir un développement harmonieux de l'IA. Les implications sociales et politiques de l'IA ont également une dimension géopolitique. L'impact de l'IA sur l'emploi, les inégalités, la démocratie, les libertés individuelles, et les valeurs culturelles varie selon les contextes nationaux et peut créer des tensions internationales. Les modèles de gouvernance de l'IA diffèrent entre les pays, certains privilégiant une approche plus centralisée et étatique (comme la Chine), d'autres une approche plus libérale et axée sur le marché (comme les États-Unis), et d'autres encore cherchant un modèle plus régulé et éthique (comme l'Union Européenne). Ces divergences peuvent mener à des frictions et à des difficultés de coopération internationale. Enfin, la coopération et la gouvernance internationale de l'IA représentent un enjeu géopolitique fondamental. Face aux risques et aux opportunités liés à l'IA, une coopération internationale est nécessaire pour définir des normes éthiques, des standards techniques, et des règles de gouvernance. Cependant, la compétition géopolitique et les divergences d'intérêts entre les nations rendent cette coopération difficile. La mise en place d'organisations internationales ou de forums de dialogue dédiés à l'IA est essentielle pour favoriser un développement responsable et bénéfique de cette technologie à l'échelle mondiale, et pour éviter une fragmentation géopolitique de l'IA qui pourrait être préjudiciable à tous. Noms associées à l'intelligence artificielleVoici quelques-uns des principaux noms associés à l'intelligence artificielle et aux questions philosophique et éthiques qu'elle soulève :-

|

| . |

|

|

|

|||||||||||||||||||||||||||||||

|